Big data telah menjadi bagian integral dari dunia teknologi informasi, dan pengolahan data besar menjadi semakin penting. PySpark adalah salah satu alat yang kuat yang memungkinkan kita untuk mengelola, menganalisis, dan memproses data besar dengan mudah menggunakan Python.

PySpark memanfaatkan kemampuan distribusi Spark untuk mengelola dataset yang sangat besar. Ini membuatnya menjadi pilihan populer dalam berbagai industri, mulai dari analisis data bisnis hingga pengembangan kecerdasan buatan (AI). Dalam artikel ini, kita akan membahas bagaimana Anda dapat menggunakan PySpark untuk mengatasi tantangan pengolahan data besar.

Apa Itu PySpark?

PySpark adalah antarmuka Python untuk Apache Spark, yang merupakan platform analitik sumber terbuka yang dirancang untuk pengolahan dan analisis data besar. Apache Spark sangat efisien dalam mengelola dan mengolah data besar di dalam memori, sehingga cocok untuk kasus penggunaan yang membutuhkan kinerja tinggi. PySpark memungkinkan Anda untuk menulis skrip dalam bahasa Python yang berinteraksi dengan ekosistem Spark.

Cara Menggunakan PySpark Sebagai Big Data Processing

1. Menginstal PySpark

Sebelum Anda dapat mulai menggunakan PySpark, Anda perlu menginstalnya. Anda juga harus memastikan Anda telah menginstal Java di sistem Anda, karena Apache Spark berjalan di atas Java. Berikut adalah langkah-langkah instalasi PySpark:

- Instal Apache Spark: Unduh versi terbaru Apache Spark dari situs web resminya (https://spark.apache.org/downloads.html) dan ikuti instruksi instalasi yang sesuai dengan sistem operasi Anda.

- Instal PySpark: Anda dapat menginstal PySpark menggunakan pip dengan perintah berikut:

2. Memulai dengan PySpark

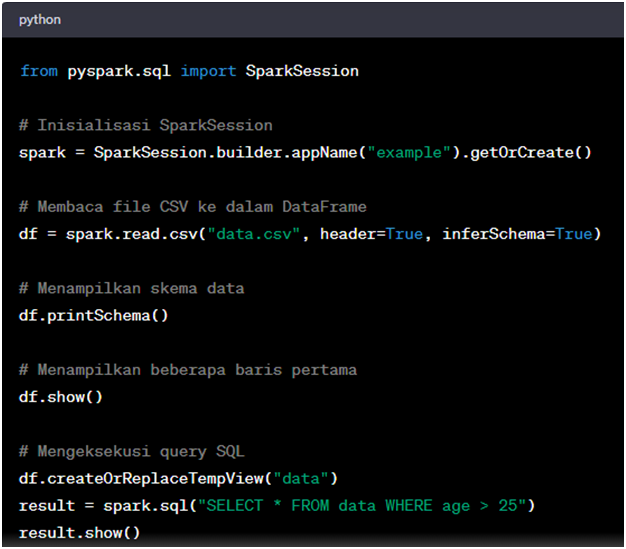

Setelah PySpark terinstal, Anda dapat memulai dengan contoh sederhana. Dalam contoh ini, kita akan membaca file CSV dan melakukan beberapa manipulasi data dasar.

Dalam contoh di atas, kita menggunakan SparkSession untuk menginisialisasi sesi Spark, membaca data dari file CSV menjadi DataFrame, menampilkan skema data, menampilkan beberapa baris pertama, dan menjalankan query SQL pada DataFrame.

3. Transformasi dan Aksi

Salah satu kekuatan besar PySpark adalah kemampuannya untuk melakukan transformasi dan tindakan (transformations and actions) pada data besar. Transformasi adalah operasi yang menghasilkan DataFrame baru dari DataFrame yang ada, sementara tindakan adalah operasi yang mengembalikan hasil atau mengubah data.

Contoh transformasi termasuk filter(), groupBy(), dan agg(), sedangkan contoh tindakan termasuk show(), count(), dan collect().

4. Cluster dan Skalabilitas

PySpark dapat digunakan pada cluster yang terdiri dari beberapa mesin, dan ini membuatnya sangat skalabel. Anda dapat dengan mudah mengubah konfigurasi cluster Anda sesuai kebutuhan dan mendistribusikan pemrosesan data di seluruh mesin. Ini sangat penting saat Anda harus mengatasi volume data besar dan memprosesnya dengan cepat.

PySpark adalah alat yang kuat untuk pengolahan data besar dengan Python. Dengan kemampuan untuk mengelola, menganalisis, dan memproses data besar secara efisien, PySpark adalah pilihan yang bagus untuk proyek-proyek yang memerlukan kinerja tinggi.

Dengan pemahaman yang baik tentang PySpark, Anda dapat memanfaatkan kekuatan Apache Spark untuk mengatasi tantangan pengolahan data besar dengan mudah dan efisien.

Program Studi S1 Teknik Informatika di Universitas Mahakarya Asia memberikan kesempatan bagi mahasiswa untuk mempelajari berbagai teknologi canggih seperti PySpark.

Dengan dukungan fasilitas laboratorium yang modern serta komunitas yang aktif, mahasiswa dapat mengasah kemampuan teknis mereka dalam memproses data besar. UNMAHA juga menyediakan berbagai pelatihan kewirausahaan untuk mendukung mahasiswa dalam membangun karir yang sukses di dunia teknologi.

UNMAHA tidak hanya fokus pada akademik, tetapi juga mengarahkan lulusannya untuk menjadi profesional yang siap terjun di dunia industri. Anda bisa melihat kesuksesan alumni UNMAHA dan belajar lebih lanjut mengenai perjalanan karir mereka dengan mengunjungi link alumni UNMAHA di sini.